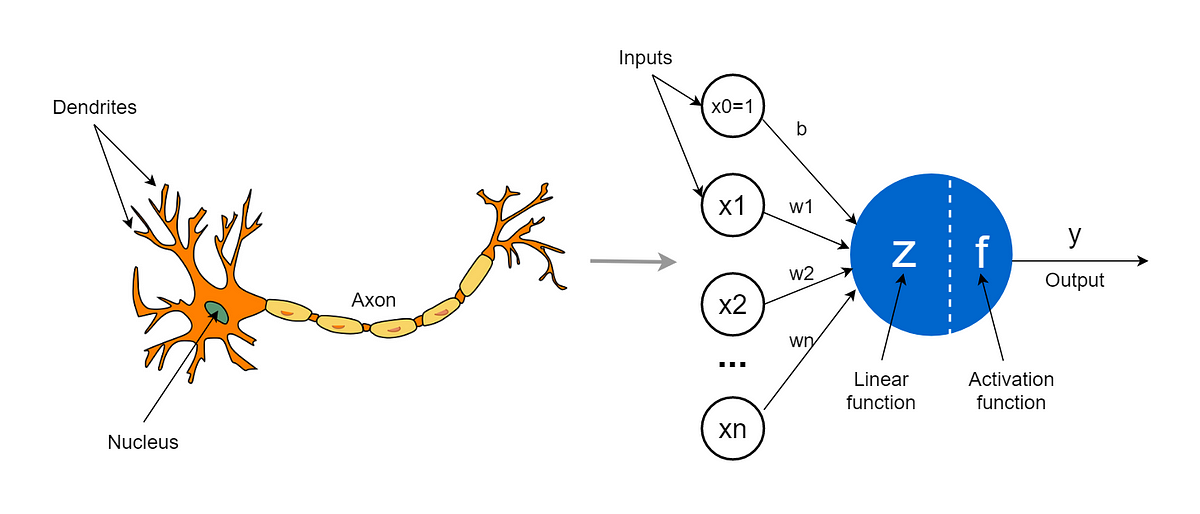

Re-jetons un œil à ce que compose un réseau de neurones:

Les neurones

Dans un neurone, la sortie est une combinaison linéaire pondérée (poids ) des entrées plus un biais . On détermine si on doit activer la sortie du neurone grâce à une fonction d’activation qui prend ce que le neurone a calculé.

Lien vers l'original

Dans les neurones la seule variable que l’on peut influer est le poids de chaque entrée, l’entrainement va donc consister à changer le poids de chaque entrée (ou de chaque sortie ca dépend comment vous le voyez). Pour se faire l’entraînement se découpe en deux phases principales que l’on répète: la forward propagation et la Backwards propagation.

La forward propagation consiste juste à envoyer les données d’entraînement du dataset au modèle et de voir les résultats, on parle de forward car le parcours se fait de l’entrée vers la sortie. De là on calcule le taux d’erreur grâce à la fonction coût.

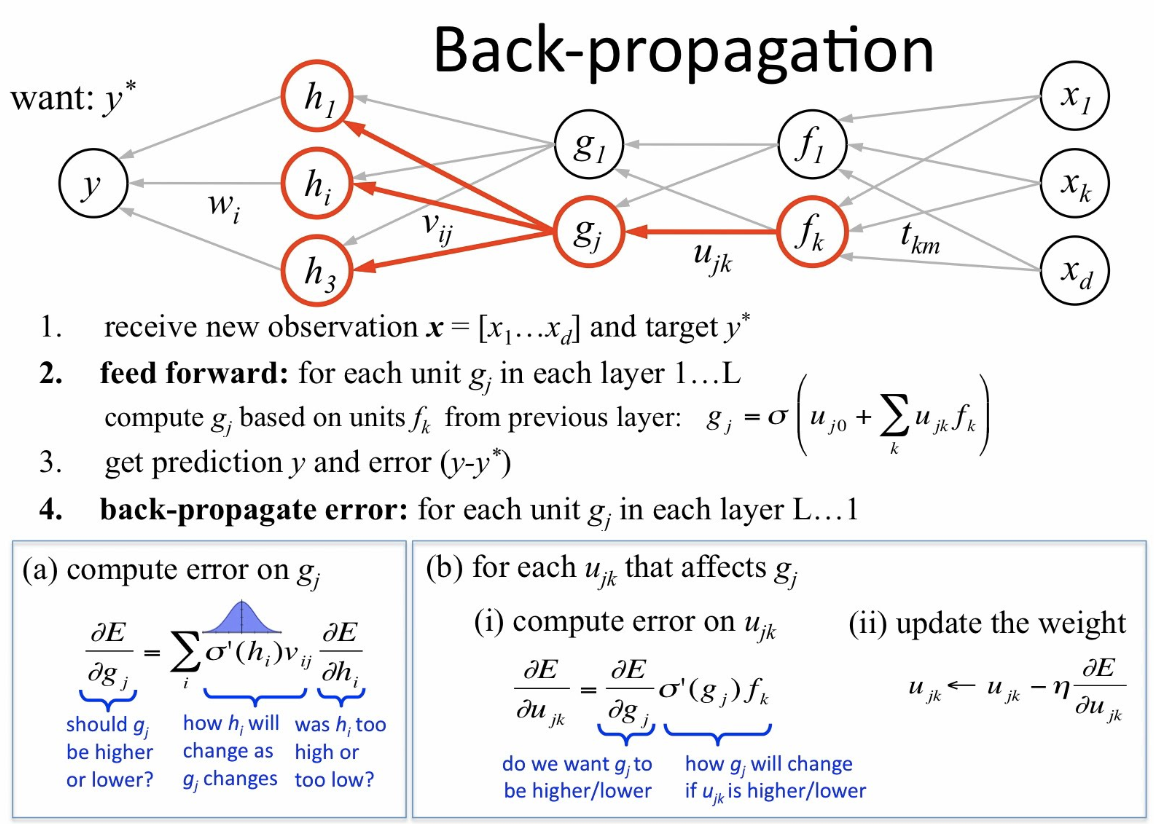

La backwards propagation elle se passe après la forward, on va faire le trajet inverse (donc de la sortie vers l’entrée), pour ajuster chaque poids. Pour trouver la valeur la plus optimale du poids on utilise le gradient descendant.

GIF d'illustration